- 付费问答

- 技术博客

- 源码买卖

原 DeepSeek-r1本地化部署

版权声明:本文为博主原创文章,请尊重他人的劳动成果,转载请附上原文出处链接和本声明。

本文链接:https://www.91mszl.com/zhangwuji/article/details/1494

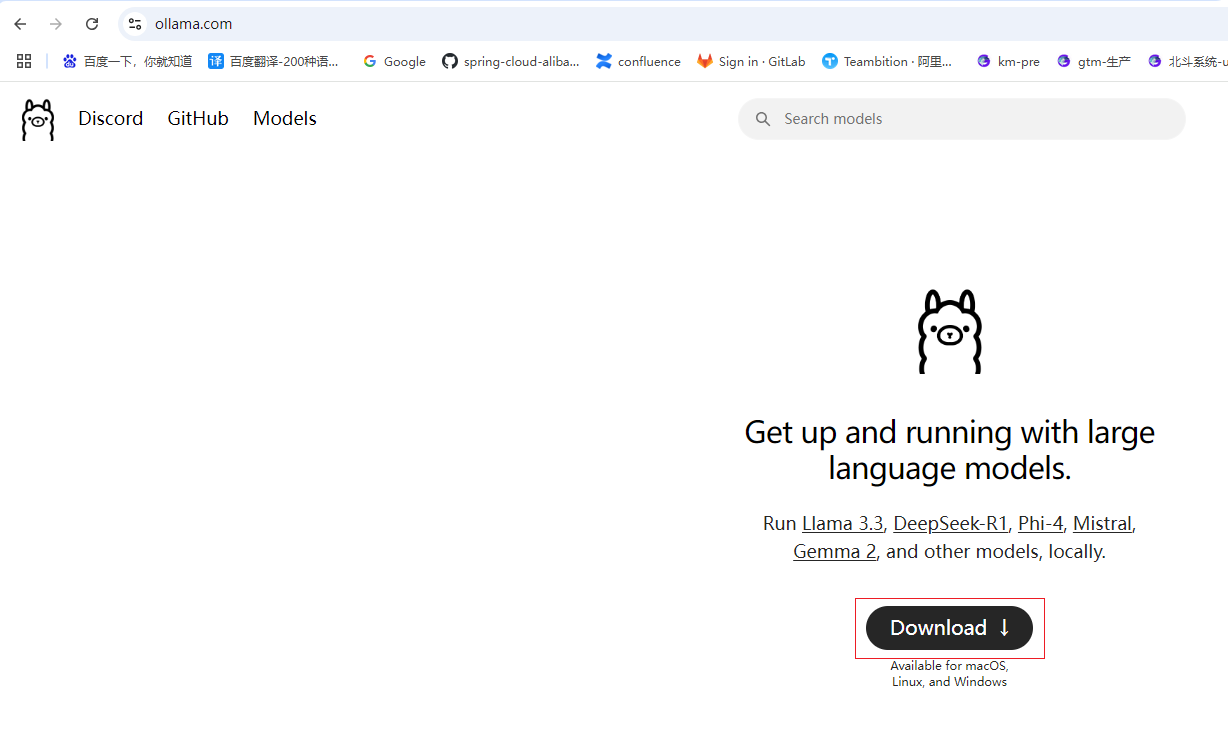

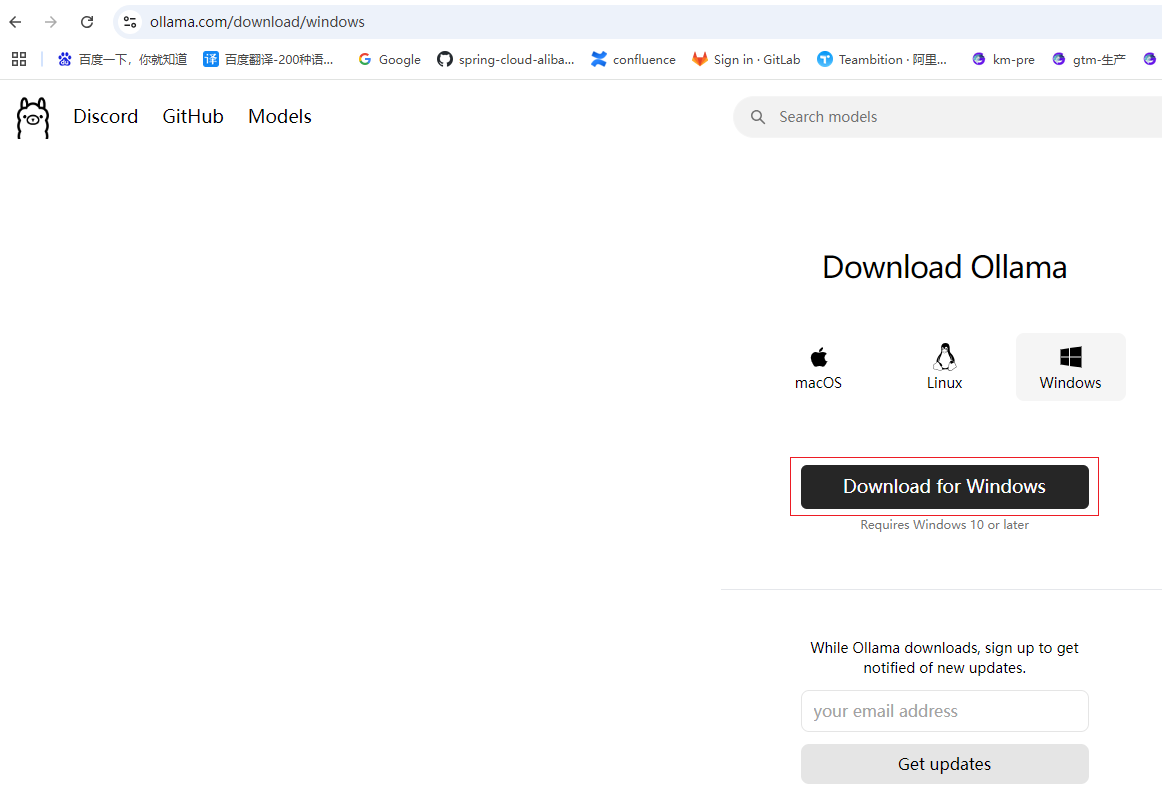

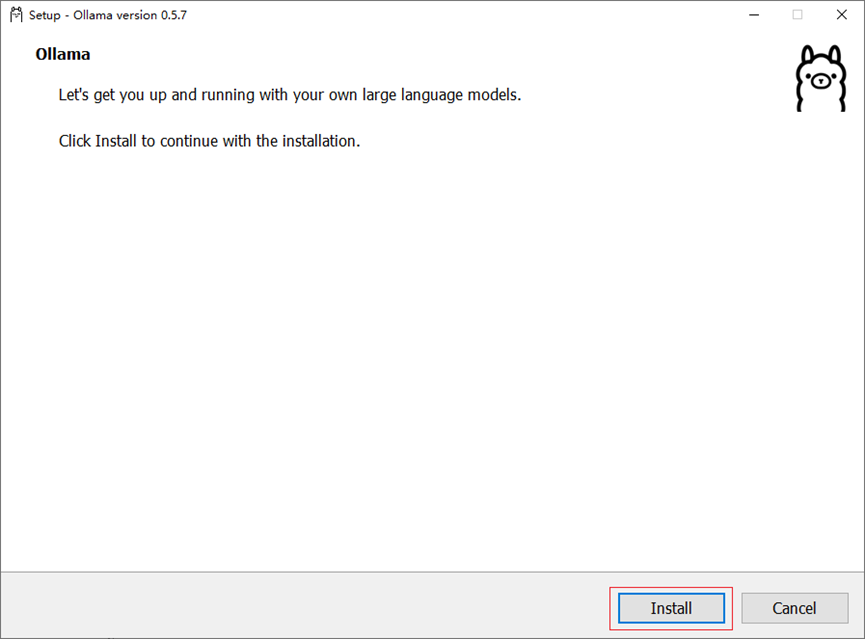

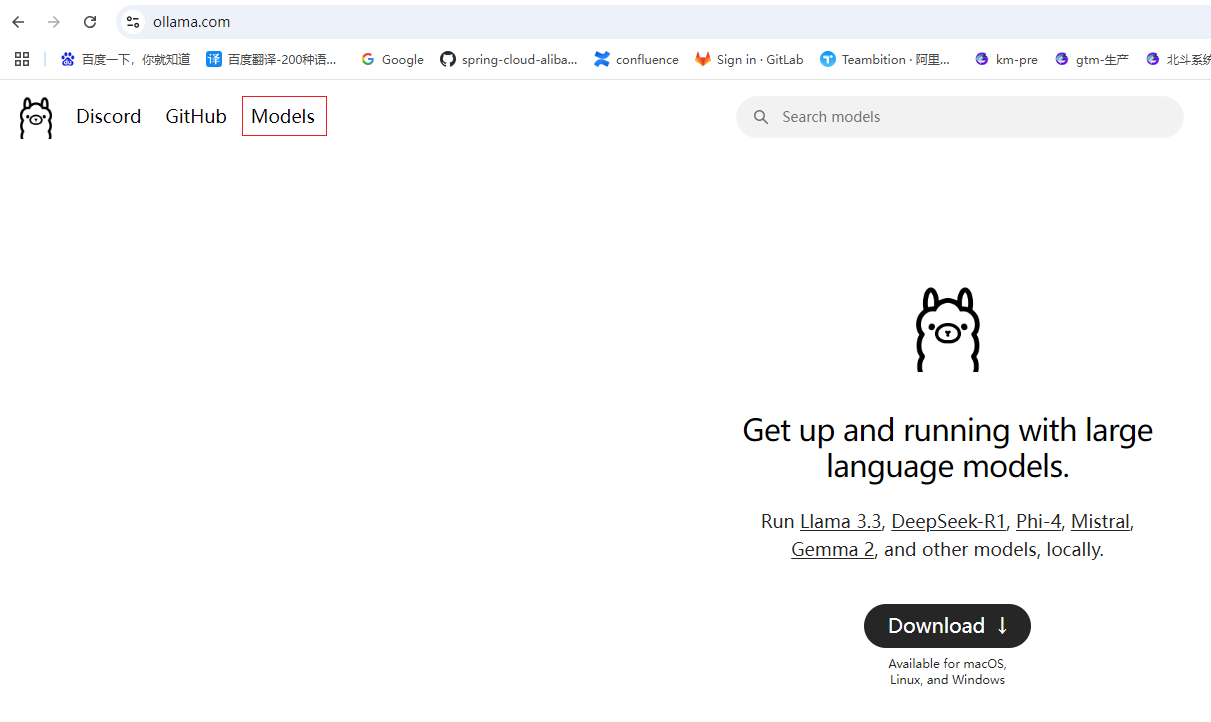

Ollama 是一个开源的大型语言模型(LLM)服务工具,主要用于在本地机器上便捷地部署和运行大型语言模型。以下是其主要特点和功能:

本地模型管理:支持从官方模型库或自定义模型库拉取预训练模型,并在本地保存和加载。

高效推理:通过 GPU/CPU 的加速,Ollama 提供高效的模型推理,适合本地化应用或需要控制数据隐私的场景。

多种接口访问:支持命令行(CLI)、HTTP 接口访问推理服务,并通过 OpenAI 客户端实现更广泛的集成。

环境变量配置:通过灵活的环境变量,用户可以自定义推理设备(GPU/CPU)、缓存路径、并发数、日志级别等

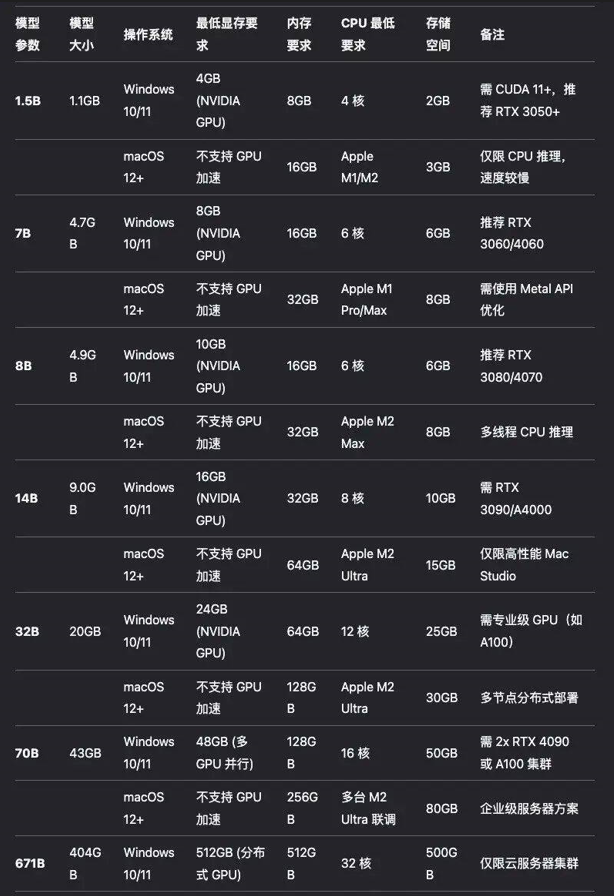

不同的模型参数对硬件的要求

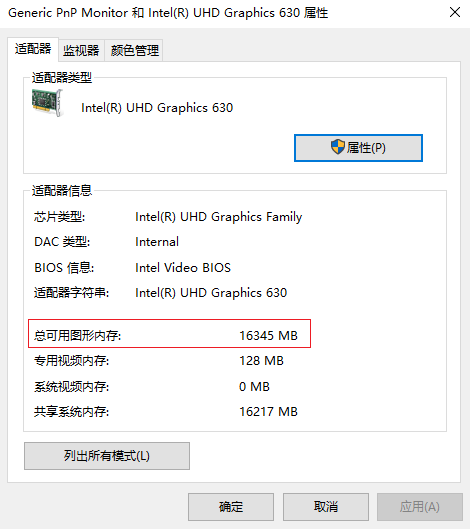

2.2)查看自己电脑的显存大小

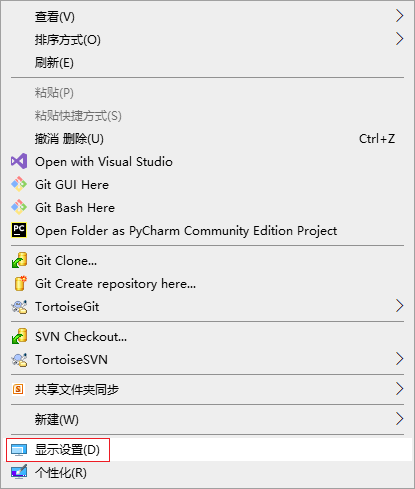

桌面点击右键 > 显示设置

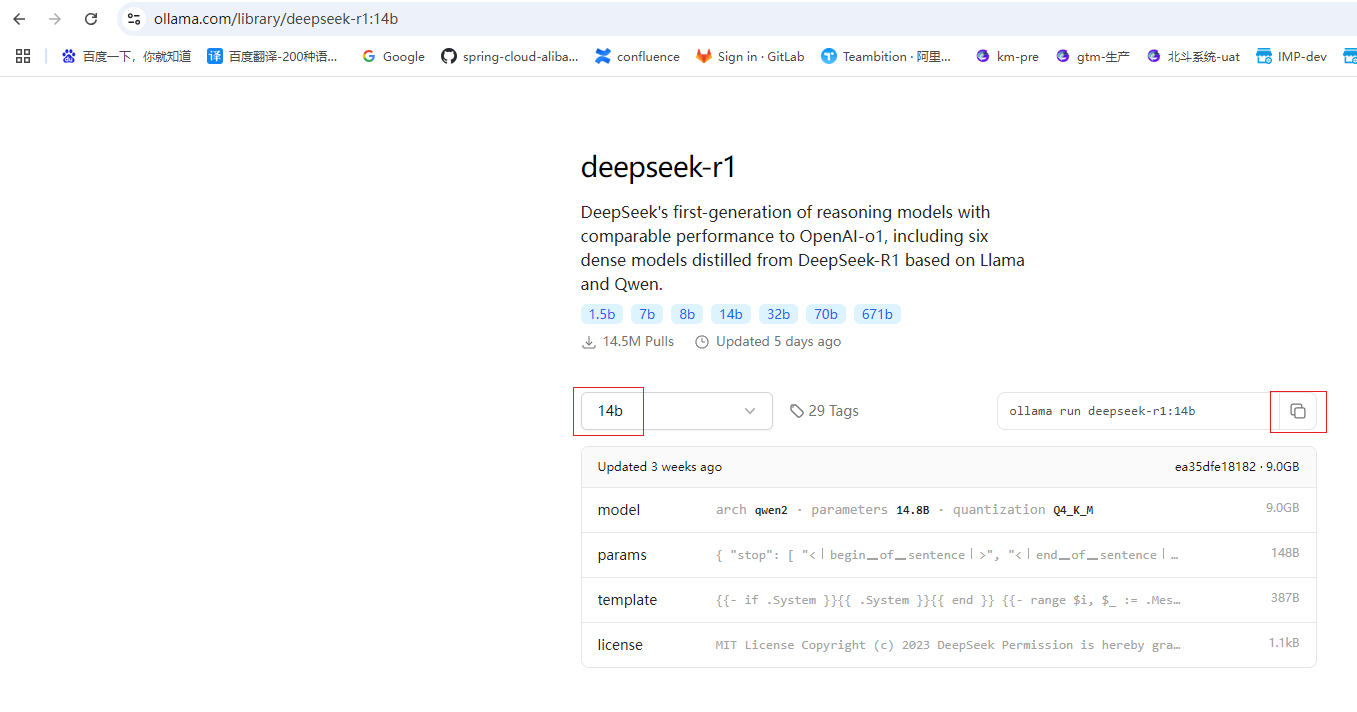

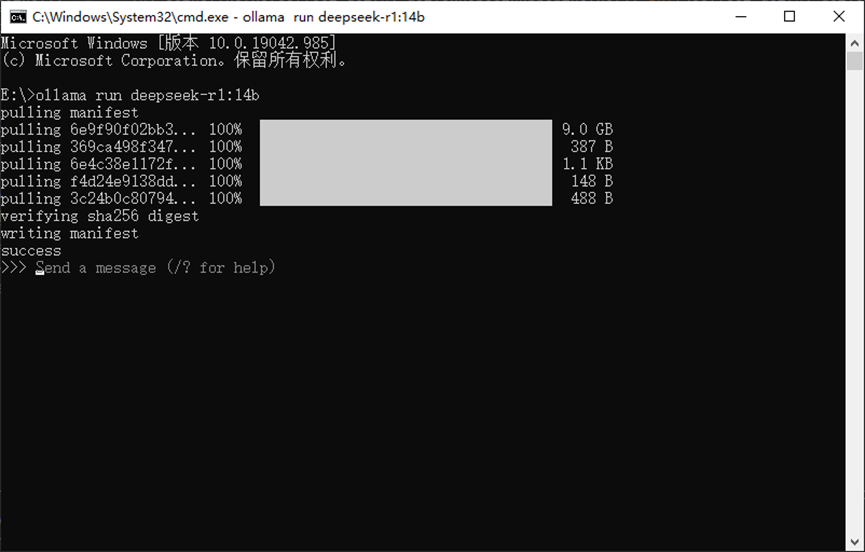

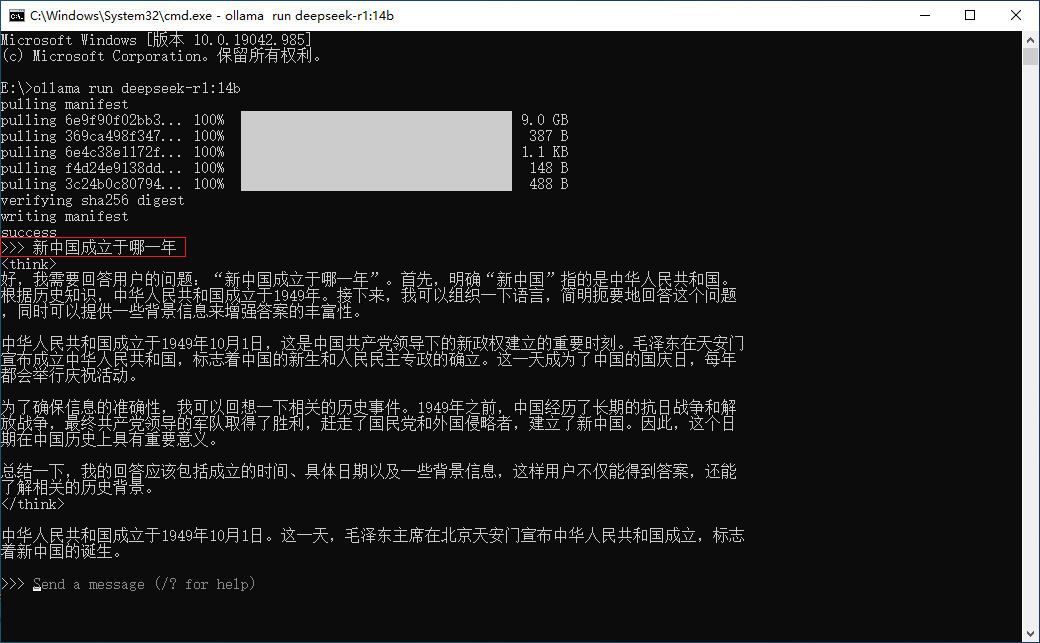

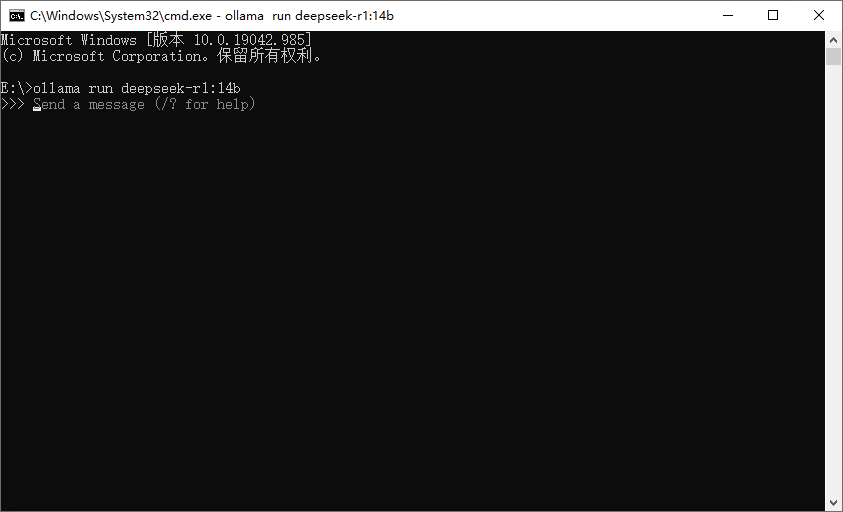

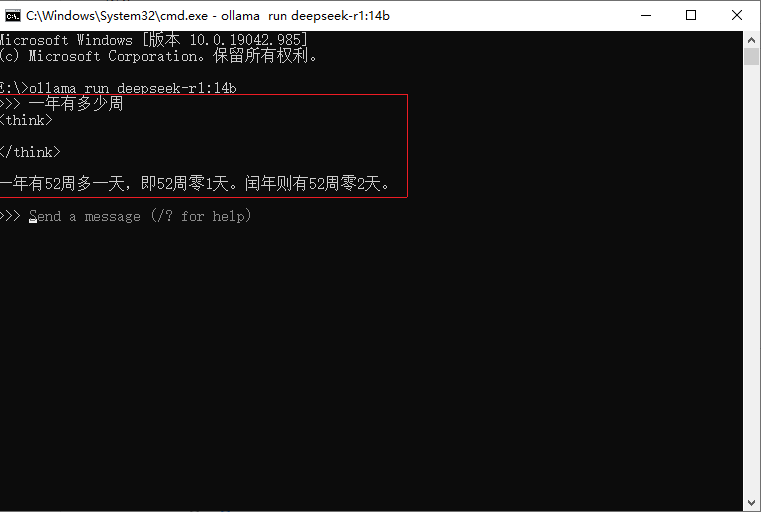

2.4)cmd打开窗口,然后粘贴刚才复制的命令:ollama run deepseek-r1:14b,耐心的等待一段时间,下图是下载完成的截图

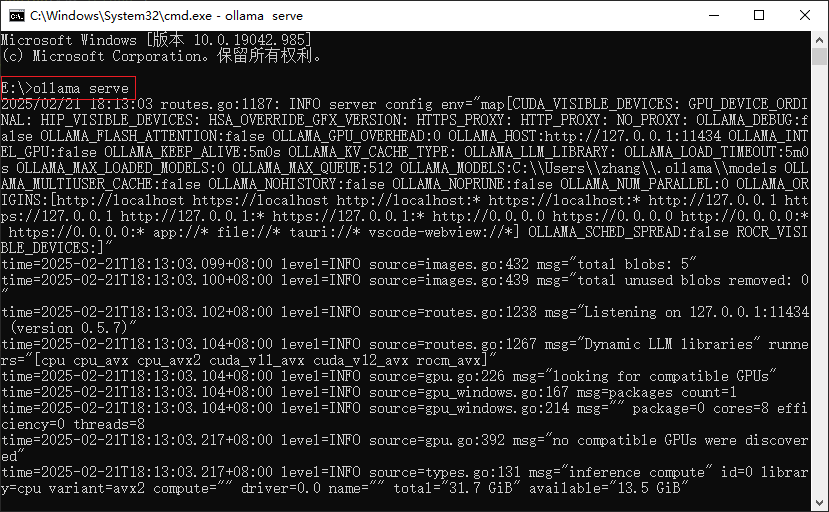

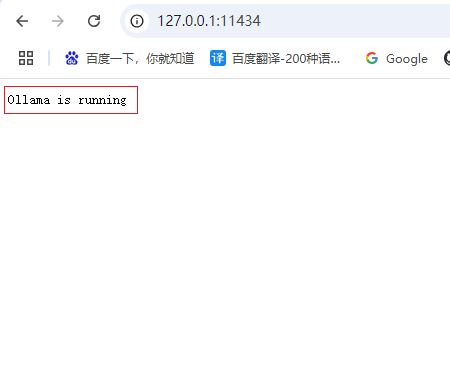

4.1)启动ollama

ollama serve

ollama run deepseek-r1:14b

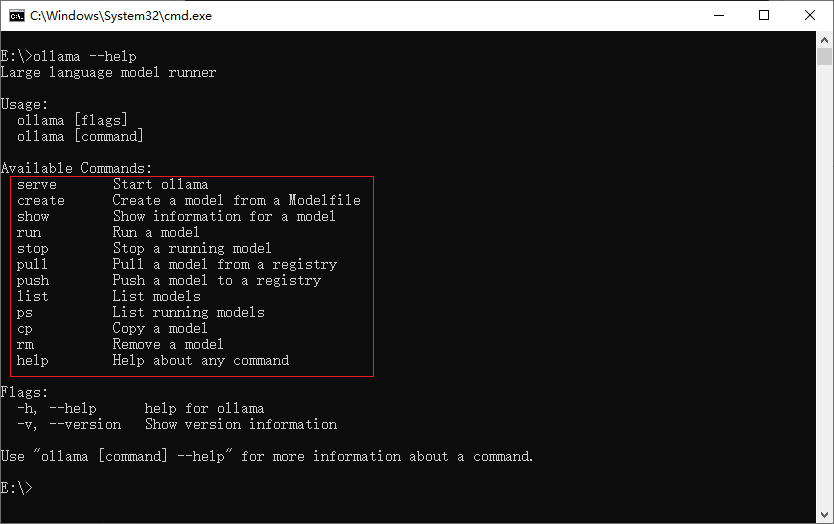

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

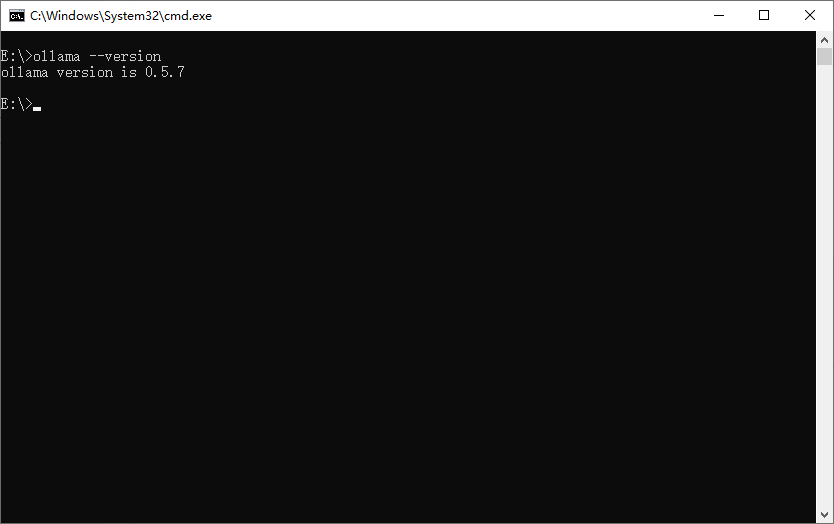

ollama --version

2025-02-12 17:24:45 阅读(410)

名师出品,必属精品 https://www.91mszl.com