- 付费问答

- 技术博客

- 源码买卖

原 elasticsearch-analysis-ik自定义扩展词库

版权声明:本文为博主原创文章,请尊重他人的劳动成果,转载请附上原文出处链接和本声明。

本文链接:https://www.91mszl.com/zhangwuji/article/details/1397

docker pull nginx:1.20docker run -p 80:80 --name nginx -d nginx:1.20cd /mydatamkdir nginx注意:nginx后面有个空格,然后还有个点

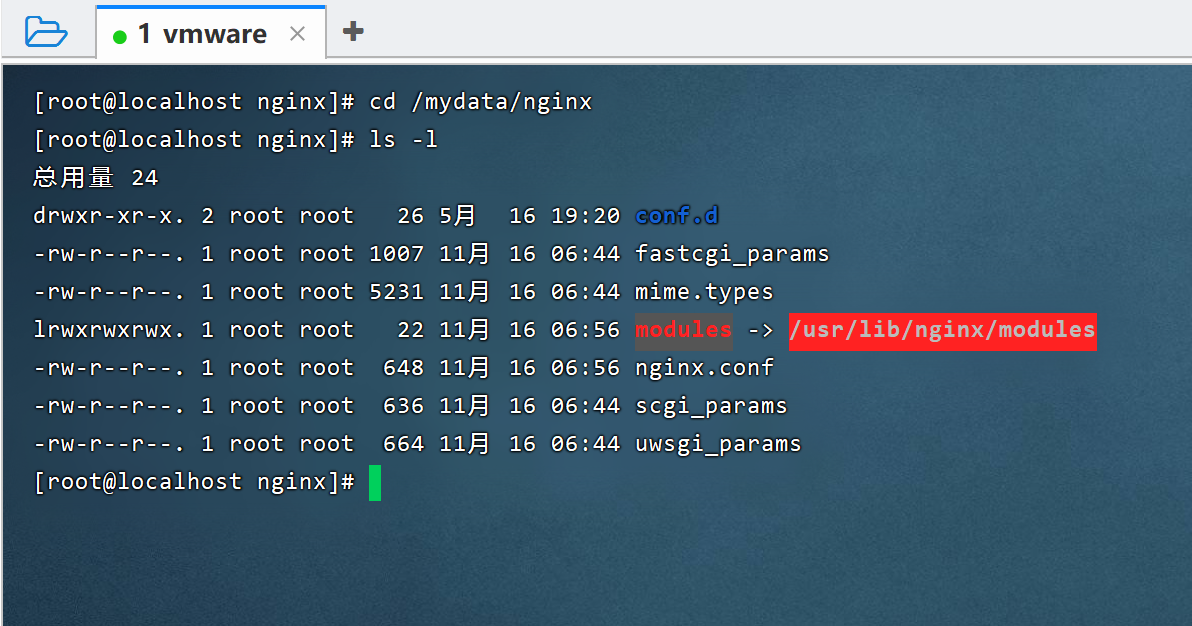

cd /mydatadocker container cp nginx:/etc/nginx .然后我们可以看到cd /mydata/nginx 目录下面多了很多nginx的配置。

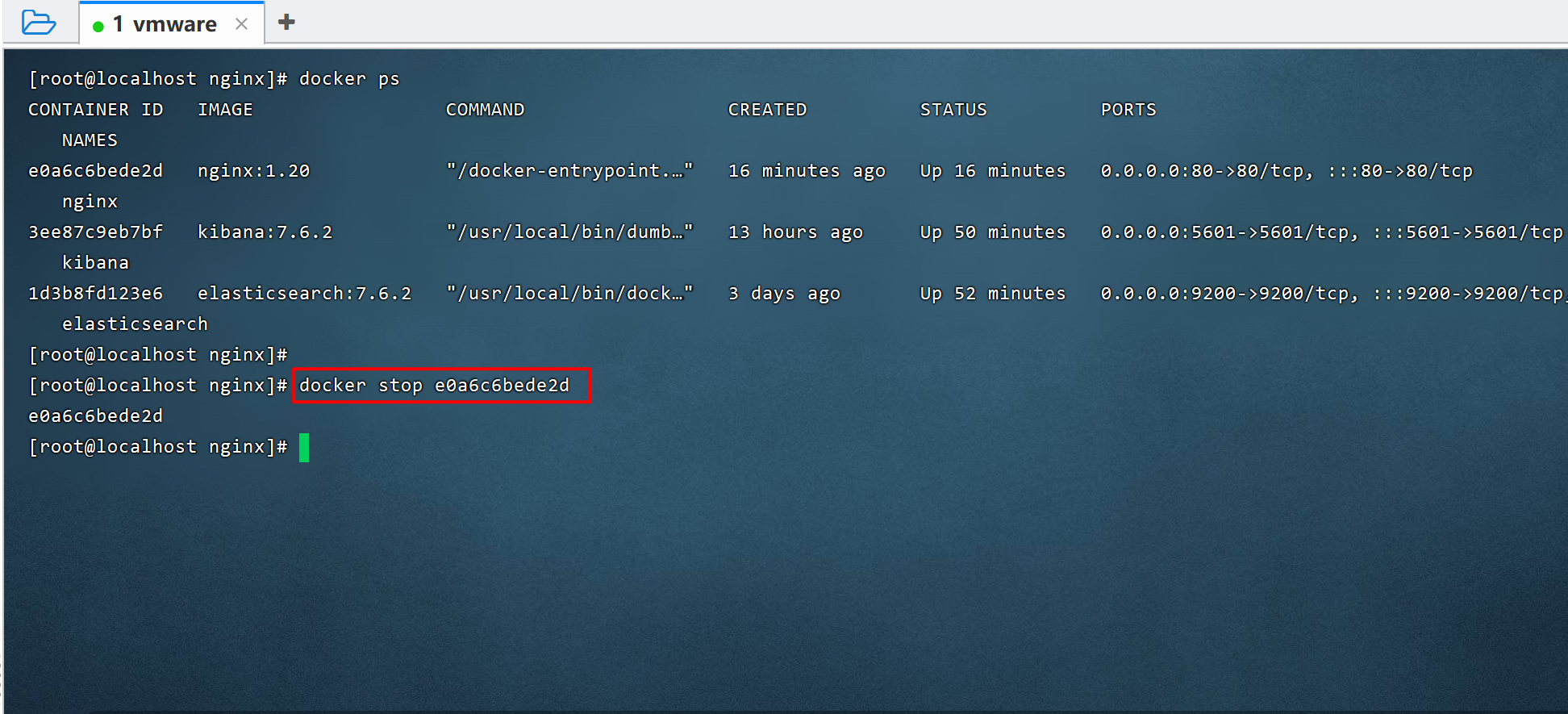

5.1)停掉nginx

docker stop e0a6c6bede2d

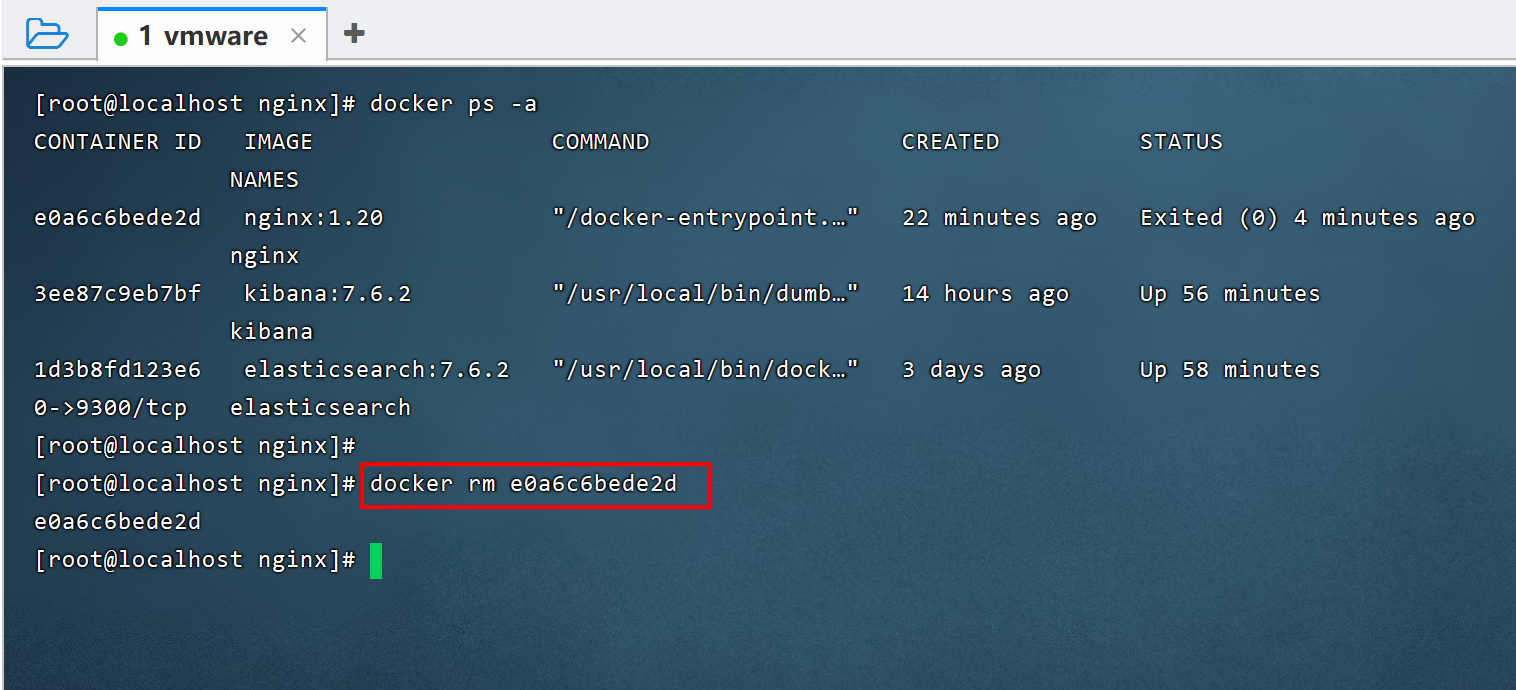

5.2)移除nginx

docker rm e0a6c6bede2d

6.1)确保当前在mydata目录下

cd /mydata6.2)将nginx文件夹重命名为conf

mv nginx conf6.3)创建nginx文件夹

mkdir nginx6.4)将整个conf文件夹全部移到nginx目录下

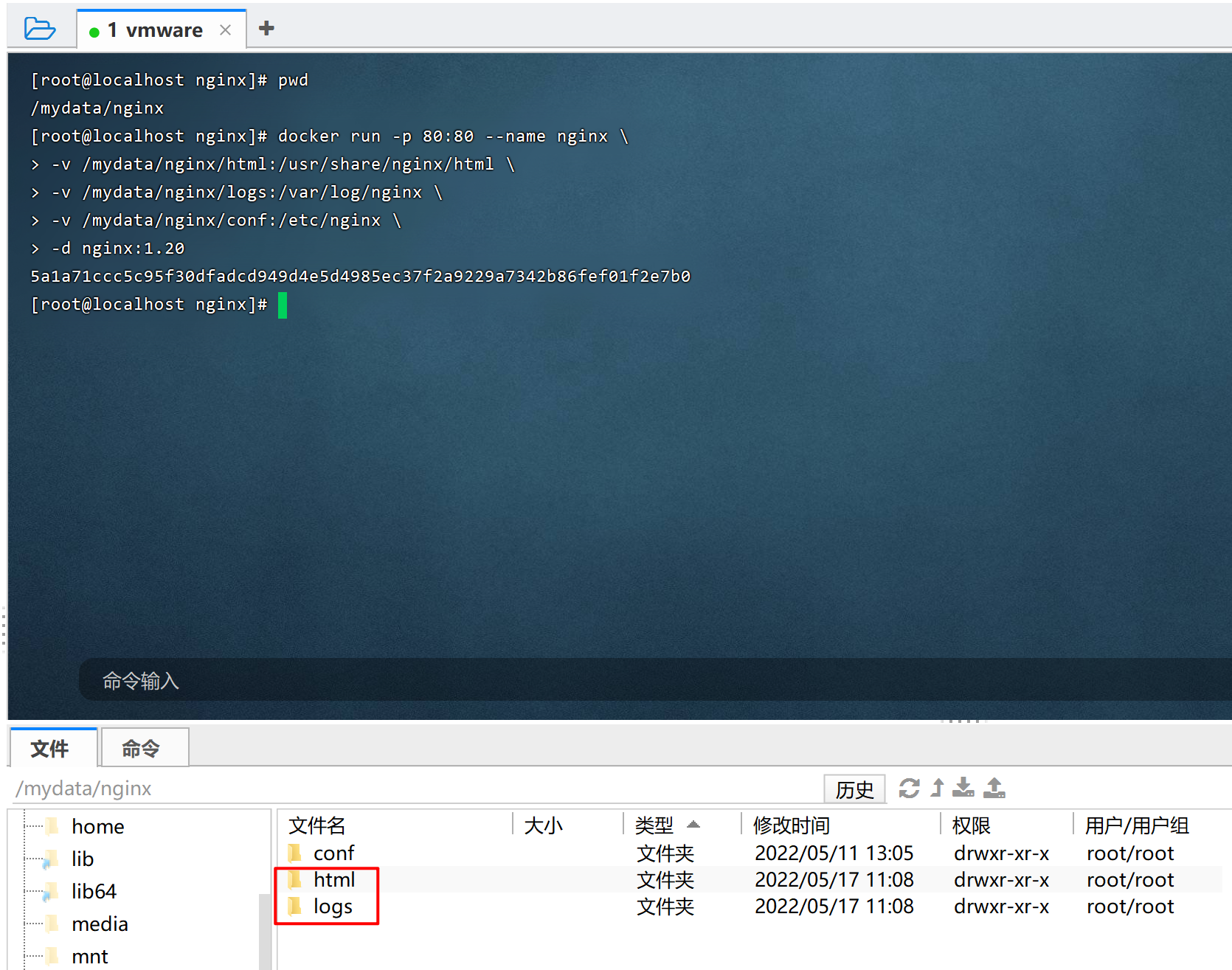

mv conf nginx/7.1)确保当前在nginx目录下

cd /mydata/nginx7.2)启动nginx

docker run -p 80:80 --name nginx \

-v /mydata/nginx/html:/usr/share/nginx/html \

-v /mydata/nginx/logs:/var/log/nginx \

-v /mydata/nginx/conf:/etc/nginx \

-d nginx:1.20启动完成后,会在/mydata/nginx 目录下创建html和logs文件夹

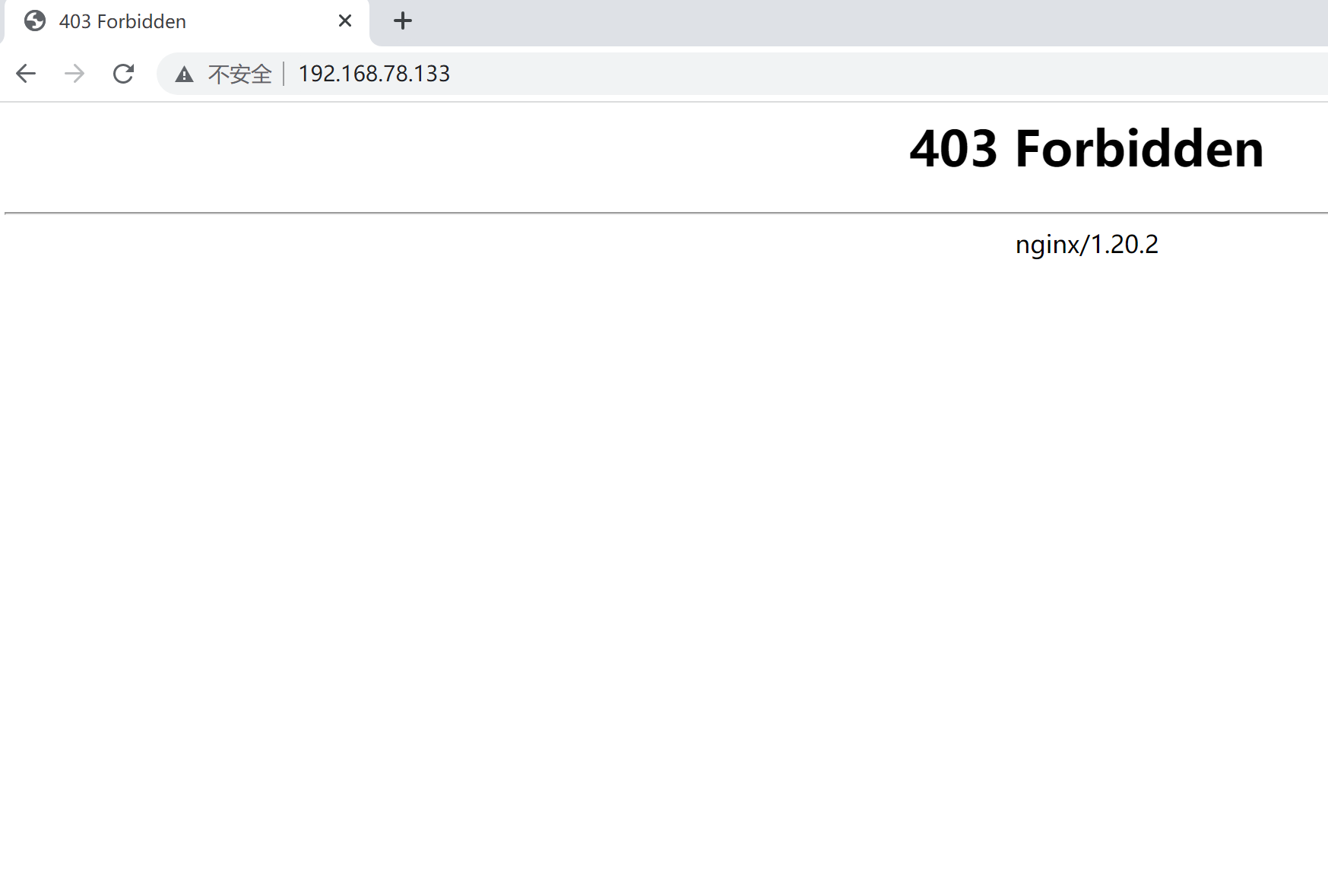

8.1)访问:http://192.168.78.133,出现如下的界面表示安装成功

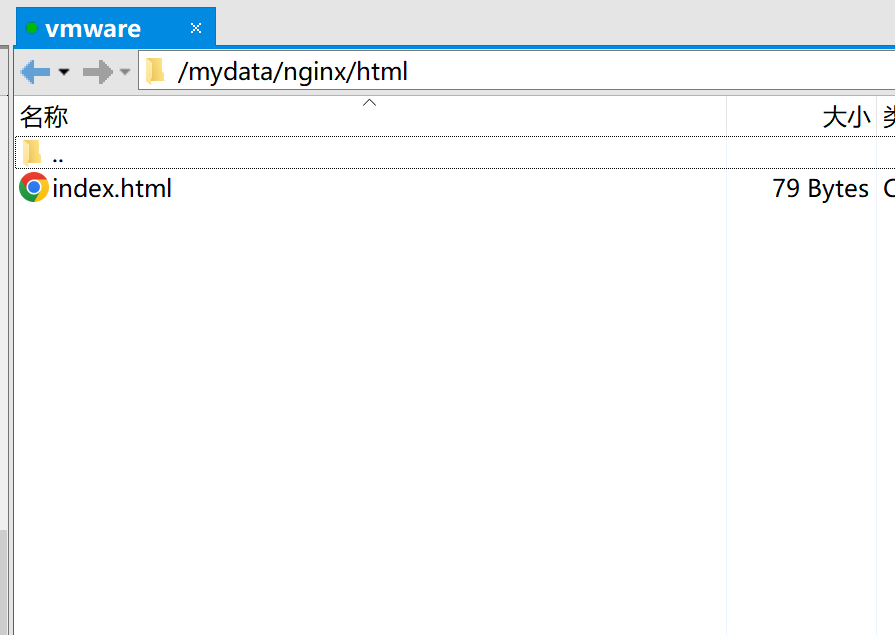

8.2)当然了我们也可以给nginx指定一个欢迎页面。

新建一个index.html,里面内容如下

<html>

<body>

<h1>welcome shop https://91mszl.com</h1>

</body>

</html>然后将其放到/mydata/nginx/html目录下

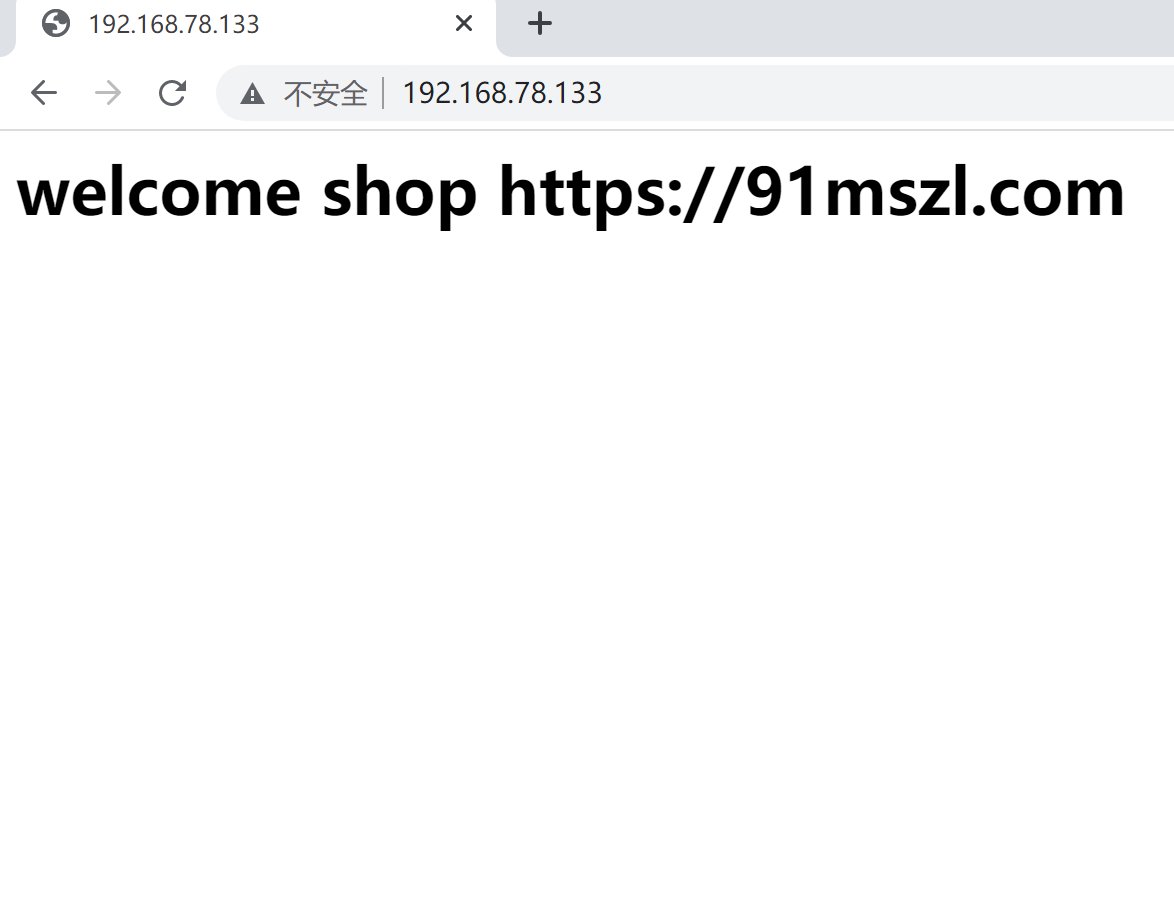

然后重新访问 http://192.168.78.133

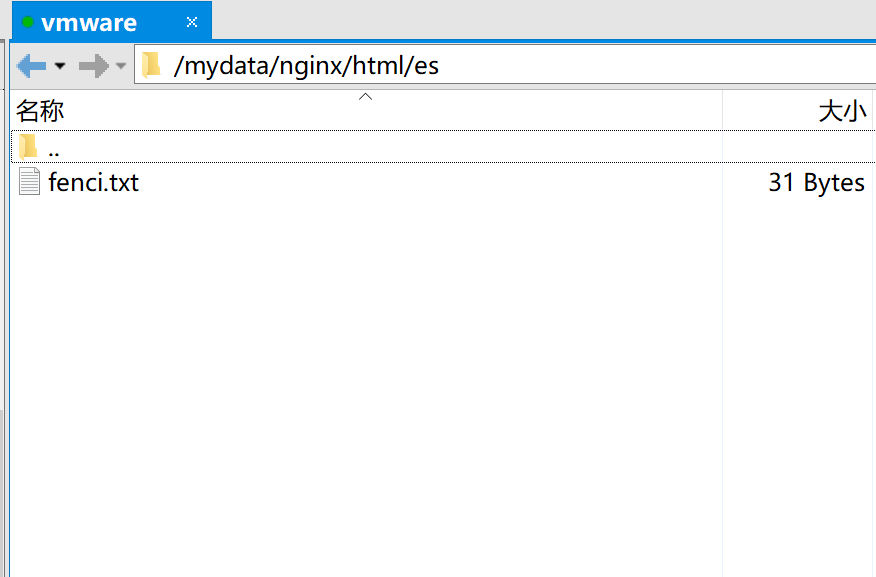

9.1)我们在/mydata/nginx/html 目录下创建es文件夹。

cd /mydata/nginx/html创建es文件夹

mkdir es9.2)我们创建 fenci.txt文件,里面的内容为

名师指路

电商

张无忌我们将其上传到 /mydata/nginx/html/es 目录下

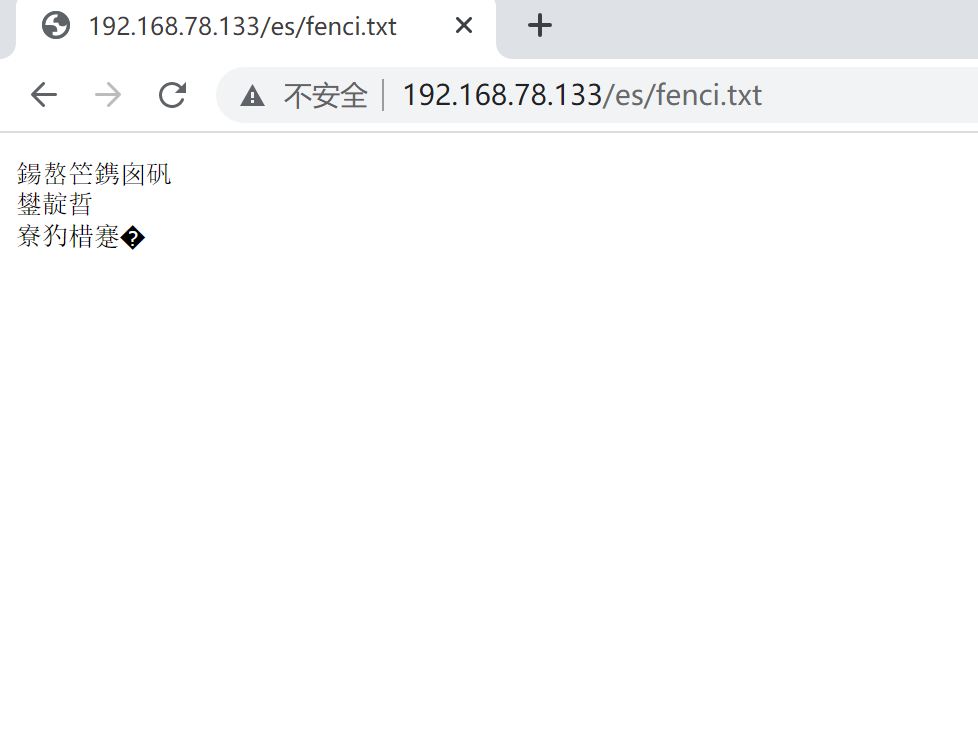

9.2)然后我们来进行访问 http://192.168.78.133/es/fenci.txt,访问乱码可以不用管

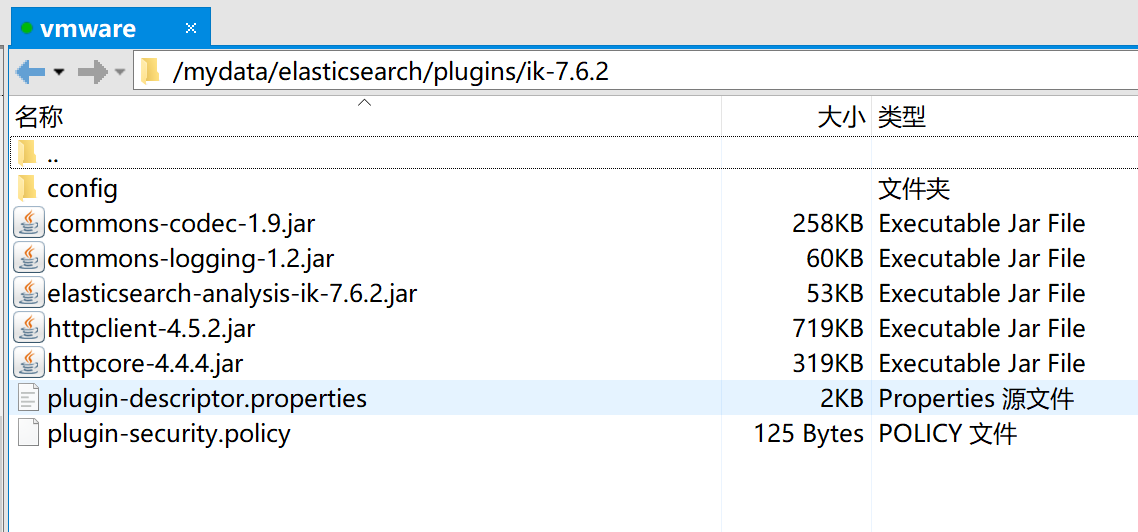

10.1)前提是已经安装好了ik分词器,安装ik分词器很简单,在github上下载:https://github.com/medcl/elasticsearch-analysis-ik/releases ,然后将下载的ik分词器解压然后上传到es的目录下即可,我们这里是将ik分词器放在 /mydata/elasticsearch/plugins目录下

10.2)进入到ik的config目录,找到 IKAnalyzer.cfg.xml文件

cd /mydata/elasticsearch/plugins/ik-7.6.2/config

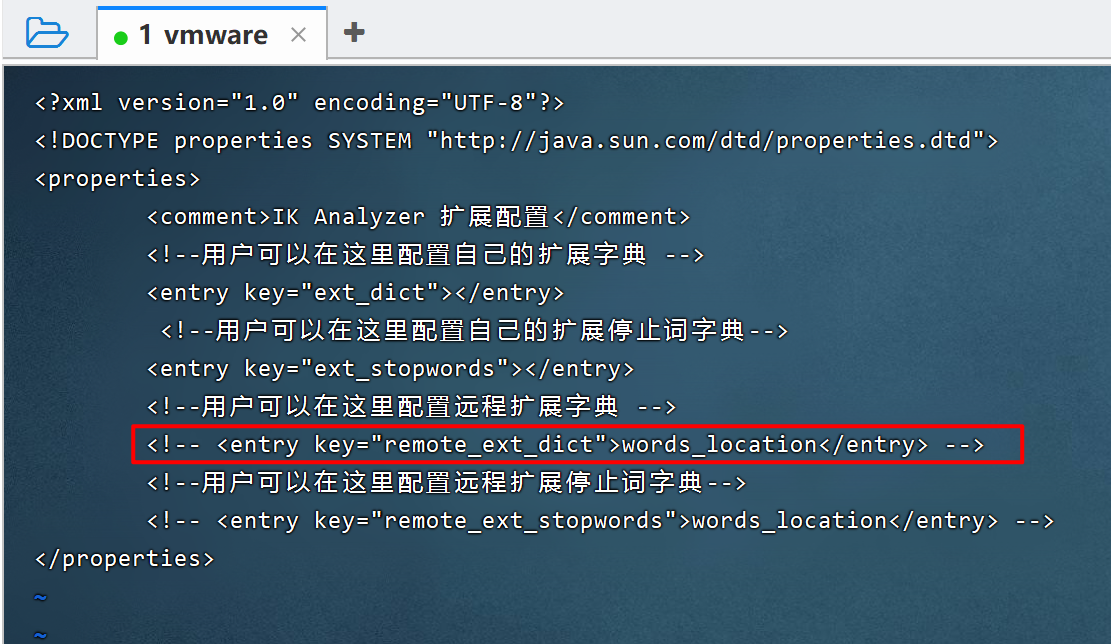

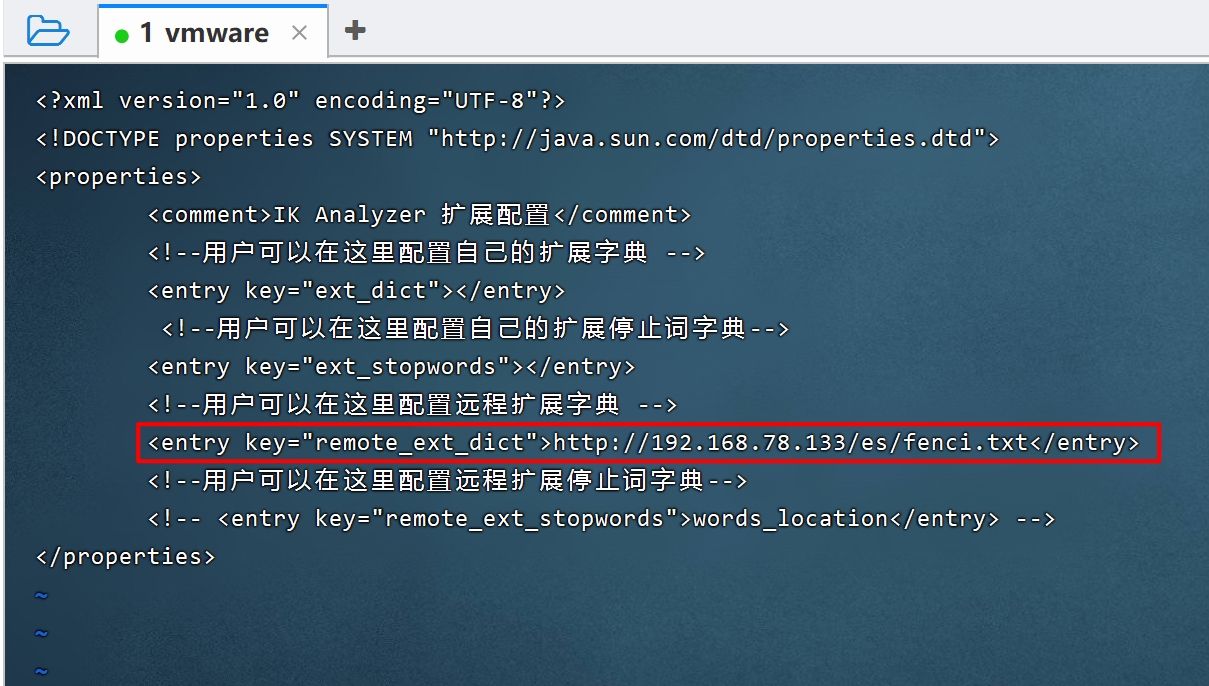

10.3)我们将配置远程扩展字典的这行代码注释打开,并指定我们配置的远程分词地址

配置完成的截图如下

10.4)重启docker中的es

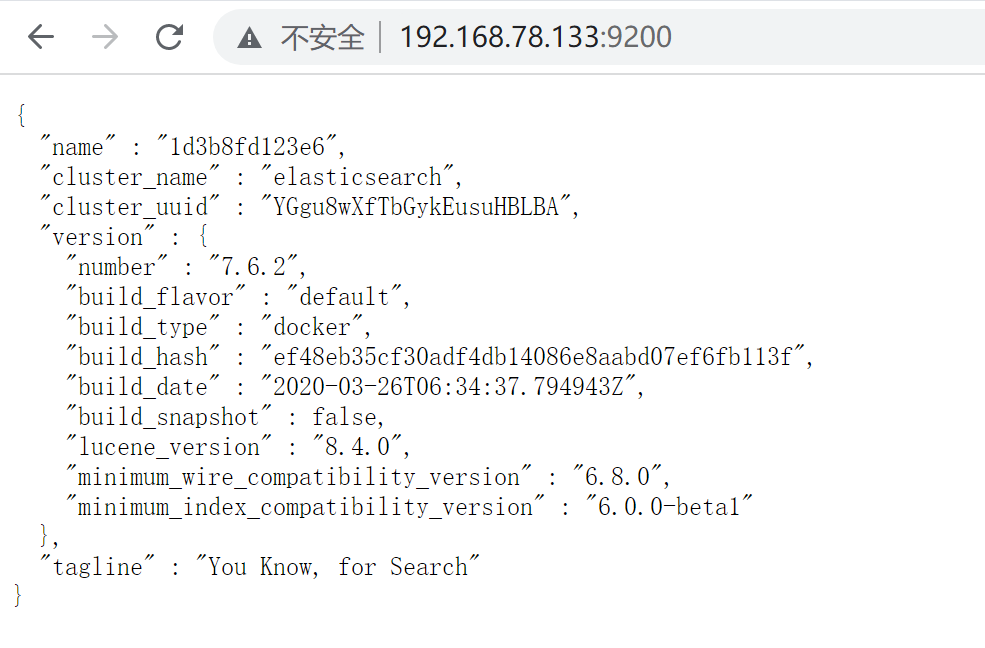

docker restart 1d3b8fd123e6

访问es确保es启动成功:http://192.168.78.133:9200

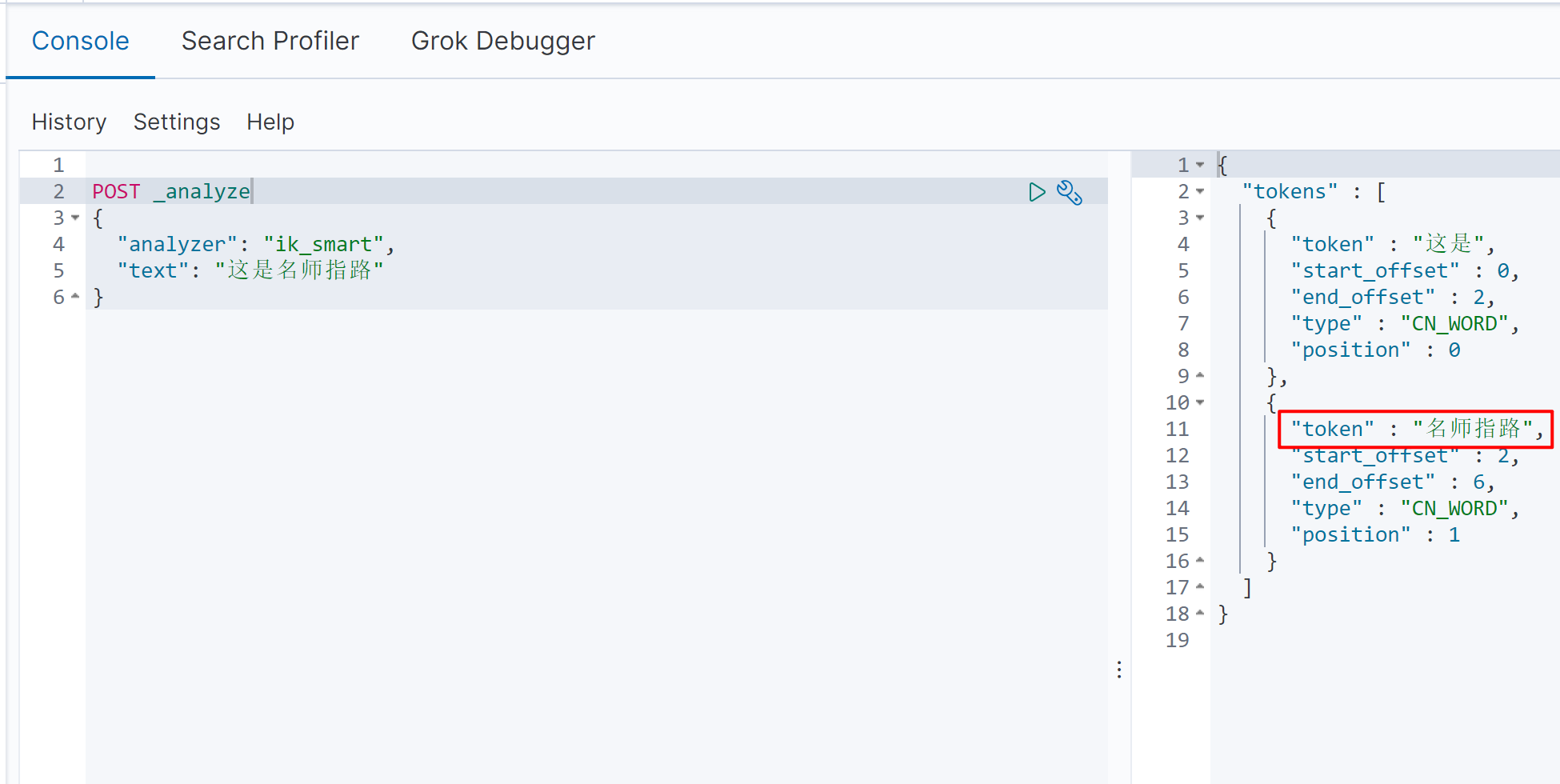

10.5)测试自定义扩展的分词效果,我们在 kibana中测试效果

POST _analyze

{

"analyzer": "ik_smart",

"text": "这是名师指路"

}我们发现名师指路这是我们在fenci.txt中自定义的词语,这里就自动的分成一个词了。到此我们就完成了ik的自定义扩展词库。

2022-05-17 10:31:32 阅读(1307)

名师出品,必属精品 https://www.91mszl.com